通过txt文件生成词云

1.调入jieba库(“结巴”)

jieba(结巴)是一款基于 Python 的中文分词库,可以将中文文本分割成一个个独立的词语。

中文文本的分词是自然语言处理中的一个重要任务。相比于英文等语言,中文的词汇是由汉字构成的,汉字之间没有空格或其他明显的分隔符,因此需要特殊的分词技术来进行分割。

jieba 库提供了多种分词模式,包括精确模式、全模式、搜索引擎模式等,可以满足不同应用场景的需求。除了分词功能外,jieba 还支持关键词提取、词性标注等功能,可以帮助用户更好地处理中文文本。

2.调入wordcloud库

一个简单易用的词云库,支持多种图形、颜色和字体。可以从文本中提取关键词,并根据词频生成词云。

1 | import jieba |

如果你之前没用过这两个库,别忘了在终端输入指令载入库!!!

1 | pip install jieba |

3.读取你本地保存的txt文件

记住,别忘了加入encoding=“utf-8”,因为如果你的文本有中文的话,需要使用utf-8模式

1 | #打开文件(只读模式),注意,由于文本内容是中文,所以需要"utf-8"编码模式 |

4.文本→字符串列表→字符串

1 | #将text文本变成一个只含有中文字符串的列表(标点符号并不在里面) |

5.通过词云,预设词云图片的形状

你可以根据你自己的需求来设定格式,第四行代码是中文字体样式,如果文本内容含有中文,你就必须使用一个字体样式,否则就会生成错误方格

1 | #运用词云,将图片设置成宽1000,高1000,背景是白色的形状 |

6.生成图片

1 | #将文本转换为图像 |

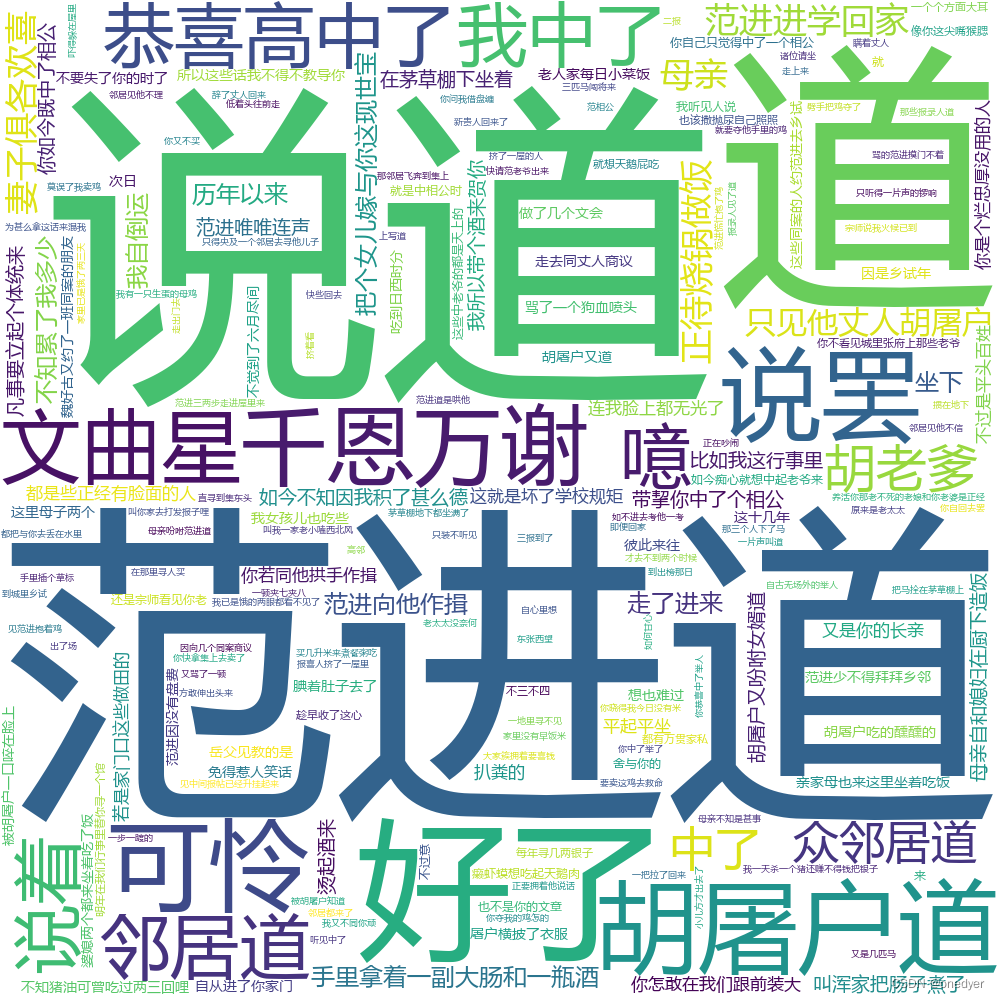

以下是生成的结果以及完整代码:

1 | import jieba |

转载前请认真阅读本站 版权协议,文章采用 CC BY-NC-SA 4.0 许可协议

💬评论

翻转卡片~

查看我的联系方式

如有事情

请扫一扫🔎

添加微信好友