B站评论爬取(IP地址、内容、大会员、性别等等)教程

2025年9月24日更新:目前B站对爬取速度进行了进一步的限制,各位如果遇到了反爬干扰,建议加入IP池或者适当降低爬取速度,如果你只是想获取评论数据,可以参考本人新发布的Edge插件,无需代码环境,直接在浏览器上对评论进行爬取与导出,而且基本上不会受到反爬机制的干扰: ✅来自本站,本站可确保其安全性,请放心点击跳转 【扩展发布】一键导出B站评论区所有评论! ldyer 前言🐈 用于爬取Bilibili(B站)视频评论的爬虫,支持爬取一级评论及二级回复,并将数据导出为CSV文件。通过输入视频的BV号,脚本会自动获取视频信息并抓取相关评论,包含用户基本信息、评论内容、IP属地、头像、会员、等级等字段。🦄🦄 🐨Github项目地址:bilibili-comment-crawler 🐒CSDN项目地址:利用Request通过bv号爬取B站指定视频下所有评论(IP地址、大会员、等级、一二级评论等等),附带源码和教程 🐼博...

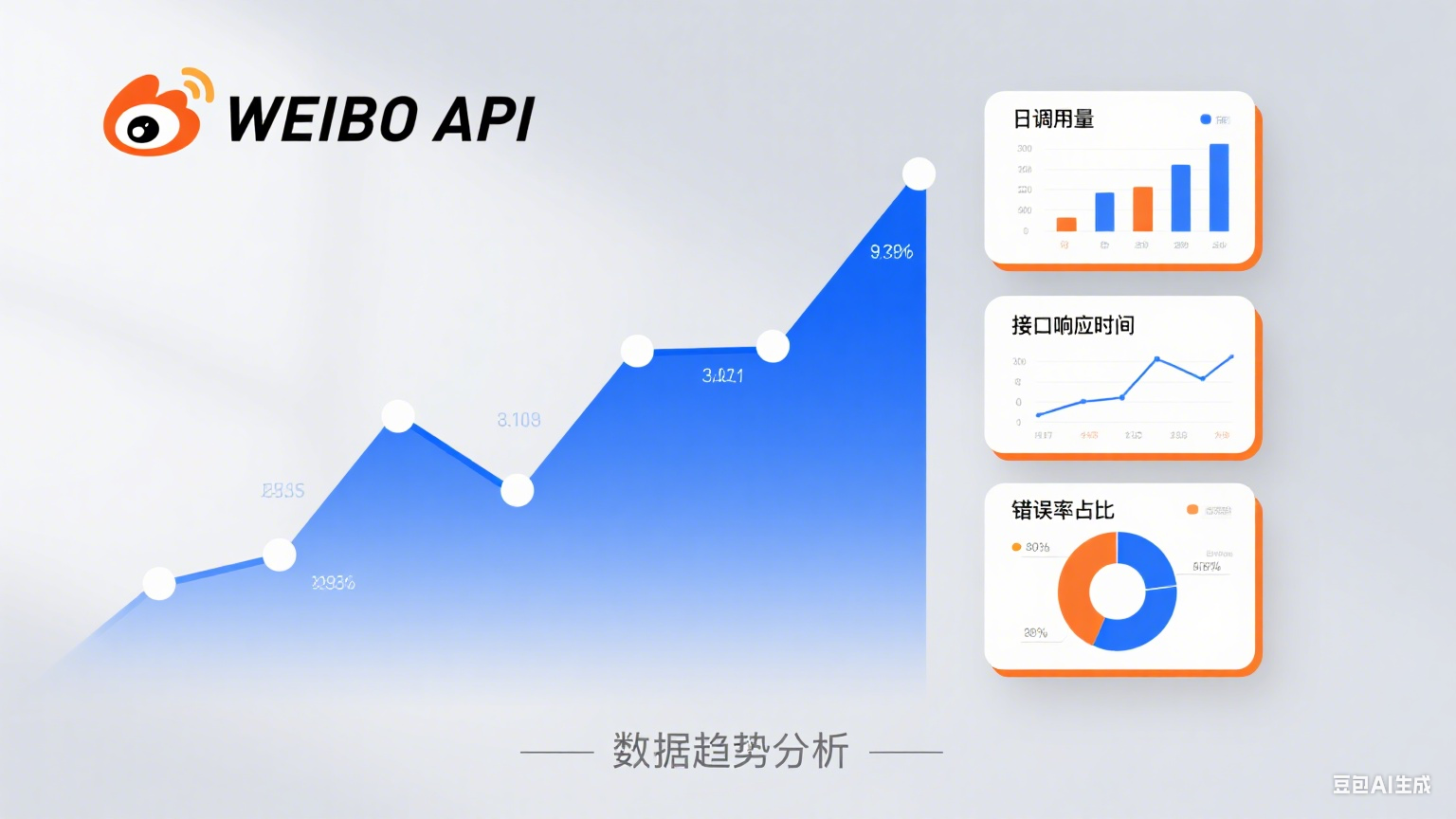

实现微博话题趋势查询接口

简介 本教程介绍如何使用 Node.js 搭建一个简单的 HTTP 服务,基于 Express 和 Axios 提供一个可以查询微博话题趋势的接口。用户可以通过 GET 请求指定关键词(search)和时间范围(time)获取相关数据。 功能概述 技术栈:Express.js(搭建服务器)、Axios(发起 HTTP 请求) 核心功能:实现一个 GET 接口 /search,通过 search 参数指定查询话题,通过 time 参数控制时间范围(如 1小时、1天、7天、30天)。 API 源地址:接口将数据请求重定向到微博的 AJAX 接口 https://m.s.weibo.com/ajax_topic/trend。 代码结构 导入模块 12const express = require('express'); // Express.js 用于搭建 Web 服务器const axios = require('axios'); // Axios 用于发起 HTTP 请求 配置服务器 1.创建 Express 实例 2.定义服务...

复制栏

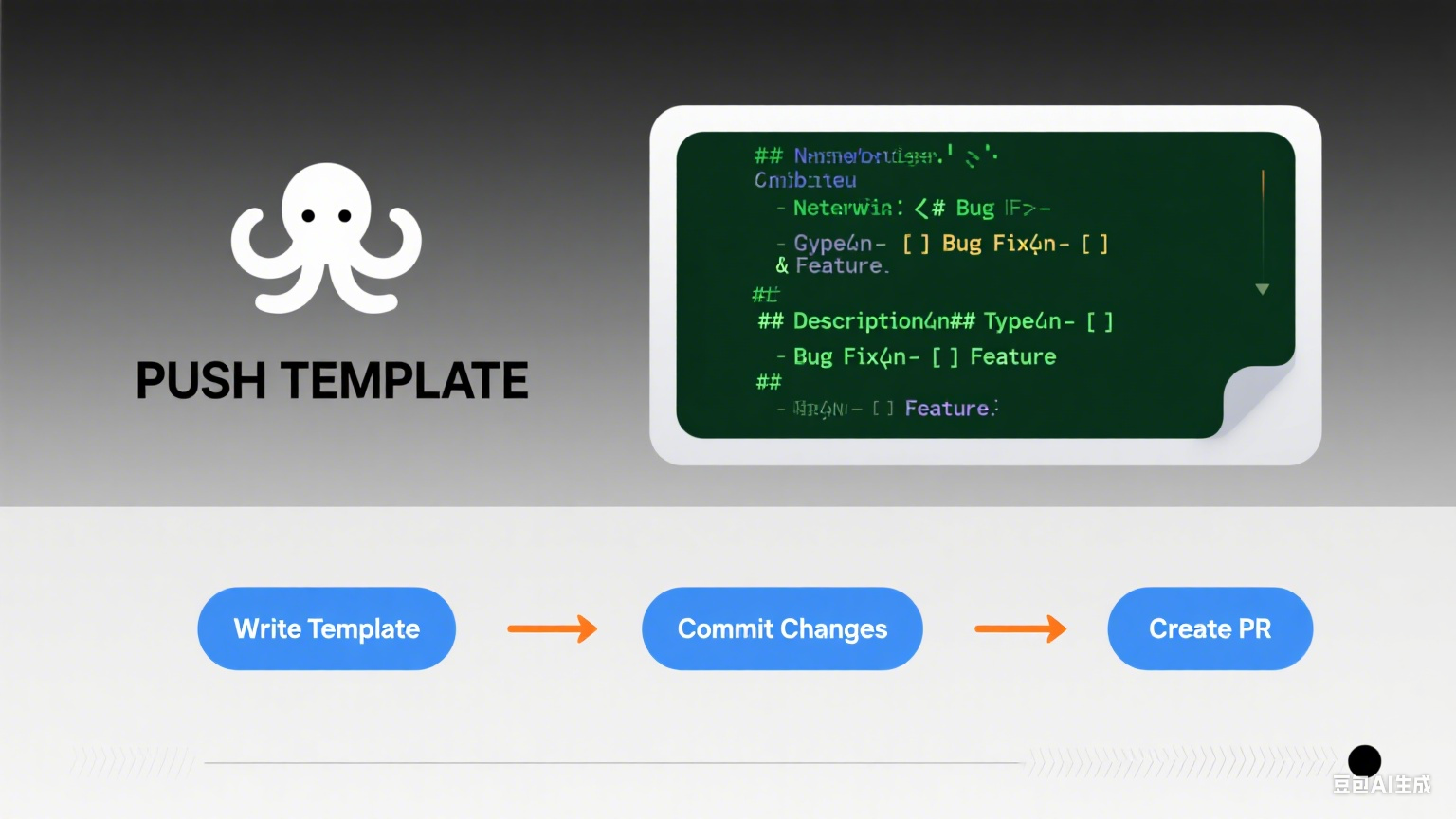

Github 推送复制模版 在 GitHub 新建空仓库 登录 GitHub → New repository → 取一个名字,如 myproject → 直接点击 Create repository,(不要勾选 README、License)。页面会给出两段提示,保留备用。 进入本地项目目录并初始化 1cd /path/to/myproject 初始化本地仓库、把当前目录所有文件加入暂存区、提交到本地仓库 1git init 1git add . 1git commit -m "first commit" 关联远程并推送 将下面命令中的 YOUR_USERNAME 和 myproject 换成自己的。 把默认分支重命名为 main(GitHub 默认) 1git branch -M main 1git remote add origin url 1git push -u origin main 后续的推送 拉取并自动尝试合并 1git pull origin main 如无冲突,直接 1git...

Hbase学习笔记

一、HBase 简介 HBase 是一个分布式、可扩展的列式存储数据库,基于 Google 的 Bigtable 设计构建。它是 Hadoop 生态系统的一部分,主要用于处理海量的结构化数据。与传统的关系型数据库不同,HBase 采用列存储而不是行存储,这使得它非常适合处理大量的稀疏数据,并且支持快速随机访问。 1.1 HBase 的特点: 分布式架构:HBase 运行在集群模式下,数据被分布在多个节点上,实现了高可用性和容错能力。 横向扩展性:可以根据需求增加节点,扩展存储和计算能力。 列式存储:数据按照列而非行进行存储,这对某些特定应用(如大规模分析、实时数据访问)非常有利。 高并发写入:适合高吞吐量的数据写入和实时数据处理。 无模式(Schema-less):在 HBase 中,不同的行可以有不同的列,可以灵活地存储结构化或半结构化数据。 1.2 HBase 的用途: 大数据存储:当需要存储大量的数据并能够进行高效的快速查询时,HBase 是理想的选择。例如,可以用于存储日志数据、传感器数据、社交媒体数据等。 实时数据分析:HBase 支持快速的随机读写,适合需要实时...

数仓学习日志(环境准备篇)

1.编辑xcall脚本 编辑xcall脚本,可以查看所有虚拟机的进程情况,这对后续很重要。 123456#! /bin/bashfor i in 虚拟机① 虚拟机② 虚拟机③do echo --------- $i ---------- ssh $i "$*"done 编辑完成后,输入 1xcall jps 如果正常的话,会显示每个虚拟机的进程 2.配置Hadoop 2.1准备 本人的hadoop是3.1.3,因为后续需要用到flume1.10.1与hadoop3.1.31不适配,所以将它升级到hadoop-3.3.4,升级之前,请将虚拟机进行快照保存,防止升级的时候出错。 2.2 安装hadoop-3.3.4 首先,安装hadoop-3.3.4到与hadoop-3.1.3相同的目录下,然后,把hadoop3.1.3中etc/hadoop/里的core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml、workers共五个文件与hadoop-3.3.4中相同文件进行替换。 替换完成后,输入以下...

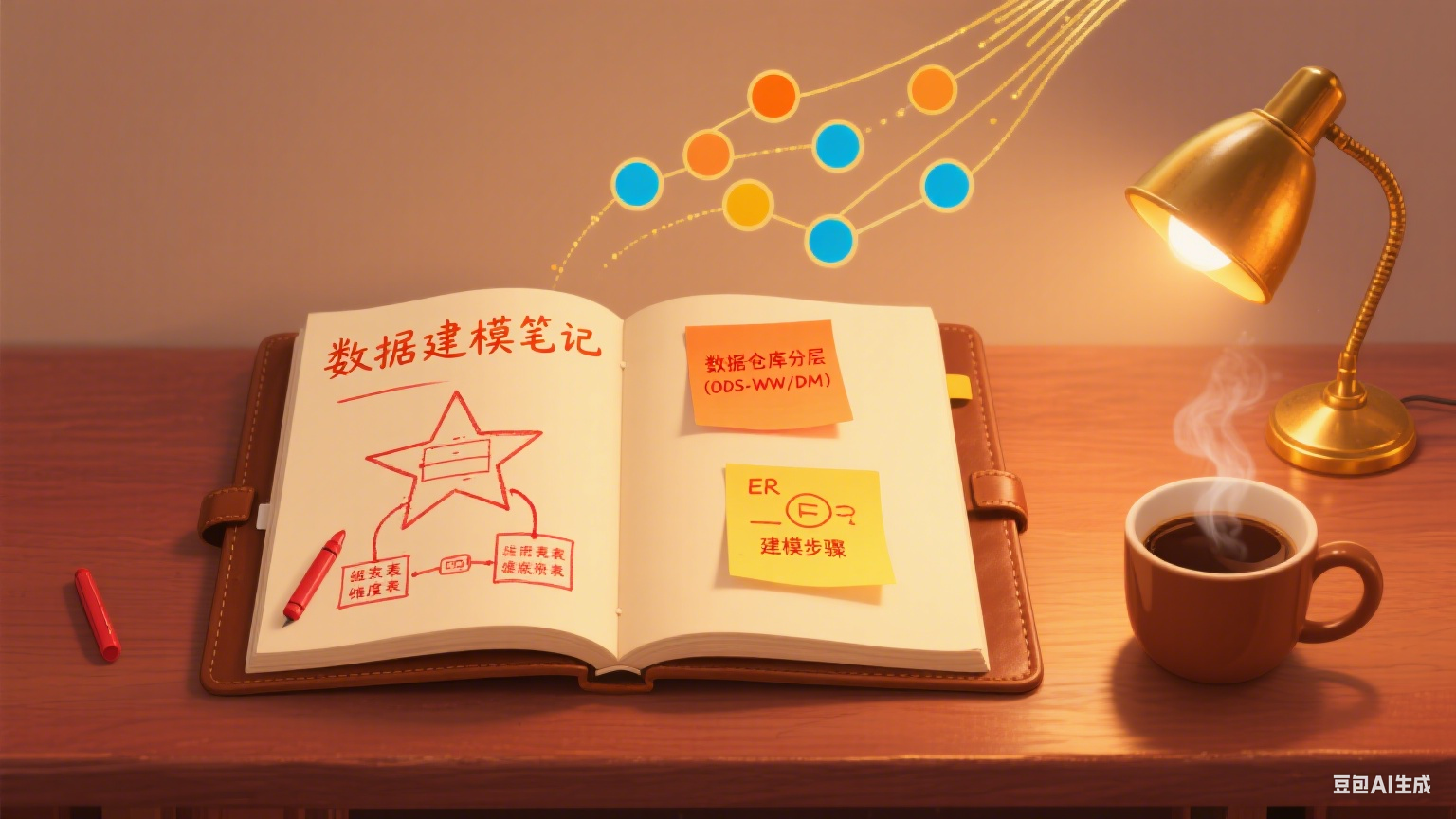

数仓学习日志(数据建模篇)

1. 模拟数据准备 1.1 生成模拟数据 先将HDFS上/origin_data路径下之前的数据删除 1hadoop fs -rm -r /origin_data/* 启动采集通道 1cluster.sh start 停止Maxwell 1mxw.sh stop 修改虚拟机①的/opt/module/applog/application.yml文件,将mock.date,mock.clear,mock.clear.user,mock.new.user,mock.log.db.enable五个参数调整为如下的值(以"2022-06-04"为例) 12345678910#业务日期mock.date: "2022-06-04"#是否重置业务数据mock.clear.busi: 1#是否重置用户数据mock.clear.user: 1## 批量生成新用户数量mock.new.user: 100## 日志是否写入数据库一份 写入z_log表中mock.log.db.enable: 0 执行数据生成脚本,生成第一天2022-06-04的历史数据 1l...

R语言学习记录

更完了,累似了! 一、基本数学运算 1.%% 计算余数 2.%/%计算所得的整数部分 3.**或^次方根 4.abs() 绝对值 5.exp() e的x次 5.round() 四舍五入函数 round(98.562,digits=2)=98.56 round(1234,digits=-2)=1200 round(1778,digits=-3)=2000 6.signif(x,digits=k) 四舍五入,x为要处理的实数,k为有效数字个数 signif(79843.597,digits=6)=79843.6 signif(79843.597,6)=79843.6 signif(79843.597,digits=3)=79800 signif(79843.597,3)=79800 7.floor(x) 小于等于x的最近整数 8.ceiling(x) 大于等于x的最近整数 9.trunc(x) 直接取整数,抹去小数 10.factorial(x) 返回x的阶乘 11.Inf 无限大 12.is.infinite(x) 判断是否无限大,如果是则TRUE,不是则FALSE 13.N...

数仓期末复习

脑子里有答案,不就是作弊吗?

Flume学习记录

1.Flume的下载与安装 本次学习在Ubuntu的Linux操作系统下进行,首先进入Ubuntu,输入指令 1wget https://archive.apache.org/dist/flume/1.9.0/apache-flume-1.9.0-bin.tar.gz 下载完成后,在目录下输入指令进行解压 1tar -zxvf 压缩包的名称 2.netcat日志采集 2.1 配置文件 进入目录下的conf文件中,创建example.conf文件,输入以下内容: 123456789101112131415161718192021## 设置Agent上的各个组件名称a1.sources = r1 #可以定义多个,r1 r2 r3 …a1.sinks = k1a1.channels = c1 ## 配置Sourcea1.sources.r1.type = netcata1.sources.r1.bind = localhosta1.sources.r1.port = 44444 ## 配置Sinka1.sinks.k1.type = logger ## 配置Channela1.ch...

Kafka学习记录

环境配置 前言 本文记录本人学习kafka的流程,采用的系统环境为Ubuntu. (一)安装Java 配置Kafka前,首先配置Java环境,输入以下命令: 12sudo apt-get updatesudo apt-get install default-jdk 其中,第一行指令是指更新Ubuntu系统中的本地软件包索引,这个命令的作用是从互联网上的软件仓库(即存储软件包的服务器)下载最新的软件包信息,并将这些信息更新到本地系统的数据库中。这个命令执行后,你的系统会知道有哪些软件包可以安装或更新,以及它们的最新版本是什么。这是在进行软件安装或更新之前应该执行的操作,因为它确保了你能够访问到最新的软件版本和依赖关系信息。 (二)安装kafka 由于直接下载官方软件包太慢了,因此用清华镜像网站进行下载,此次下载的版本是3.7.0,这是下载命令,可根据想要下载的版本进行链接选择。 1wget https://mirrors.tuna.tsinghua.edu.cn/apache/kafka/3.7.0/ 下载完成后,对压缩包进行解压,并进入该目录下: 12tar -xzf kafka...

翻转卡片~

查看我的联系方式

如有事情

请扫一扫🔎

添加微信好友

数据加载中