爬虫:爬取影片详细信息

内容

访问豆瓣电影Top250(https://movie.douban.com/top250?start=0)

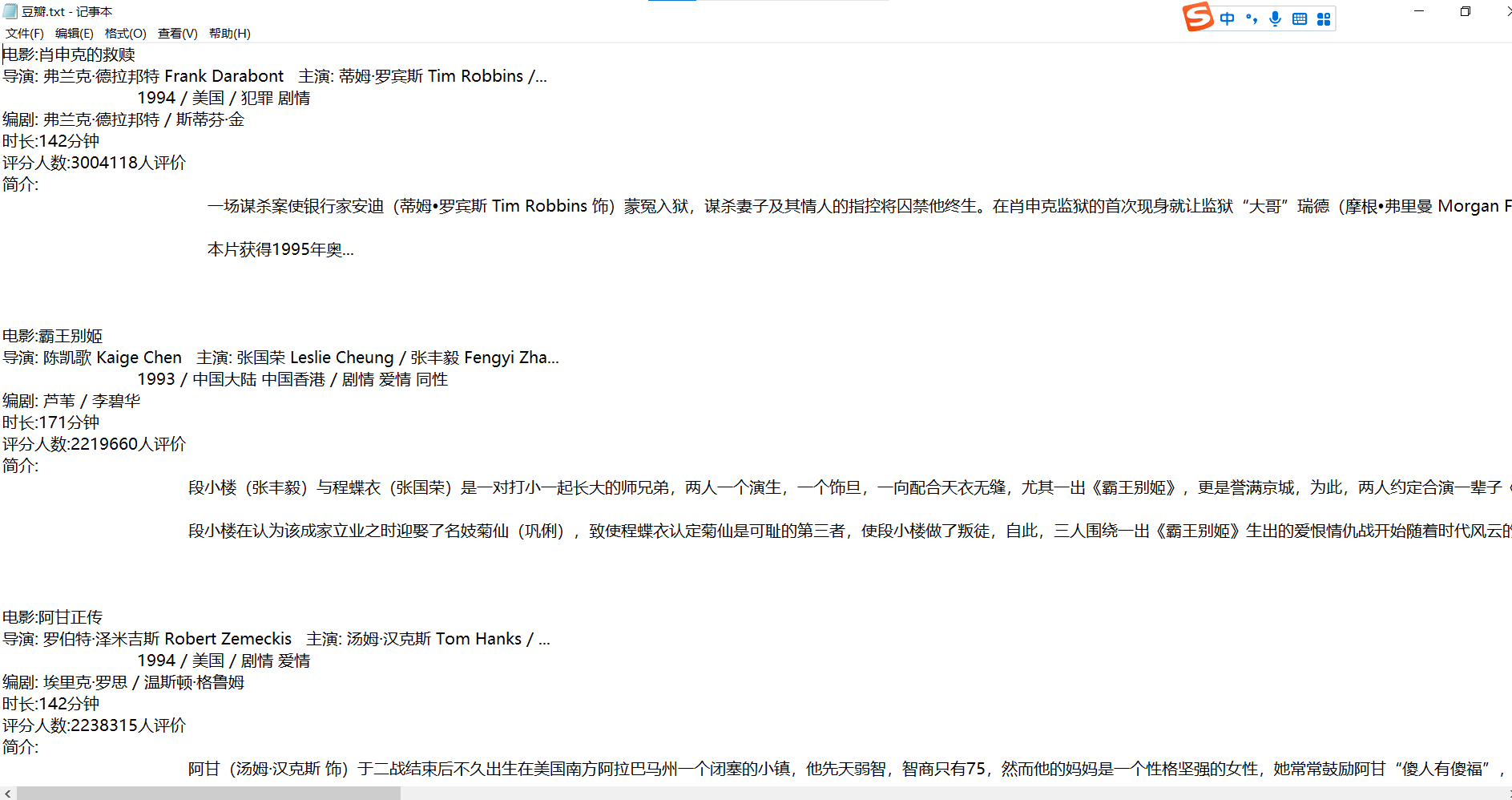

获取每部电影的导演、编剧、主演、类型、上映时间、片长、评分人数以及剧情简介等信息,并将获取到的信息保存至本地文件中。

导入库

1 | from bs4 import BeautifulSoup as BS |

打开文件和设置请求头

1 | fs = open("豆瓣.txt", 'w', encoding='utf-8') |

- fs:打开(或创建)一个名为“豆瓣.txt”的文件,用于写入数据,文件编码设置为utf-8。

- headers:设置HTTP请求头,模拟浏览器访问,User-Agent是浏览器标识,有助于避免被网站识别为爬虫。

爬取豆瓣电影Top 250

1 | for page in range(0, 250, 25): |

- for循环:遍历豆瓣电影Top 250的页面,每页25部电影,共10页(0到250,步长为25)。

- requests.get:发送GET请求到豆瓣电影Top 250的URL,start={page}参数用于指定页面的起始索引。

- BS:创建一个BeautifulSoup对象来解析请求返回的HTML内容,使用lxml作为解析器。

- select:使用CSS选择器找到包含电影信息的HTML元素。

提取电影信息并写入文件

1 | for i in content: |

- 内层for循环:遍历每页中的电影信息。

- name:提取电影名称。

- url:找到电影链接的href属性。

- sp:发送请求到电影的详细页面,并创建一个BeautifulSoup对象来解析HTML。

- mainer:提取导演、主演、类型、上映时间信息。

- writers:提取编剧信息。

- all_time:提取片长信息。

- number:提取评分人数信息。

- brief:提取电影简介。

- all:将所有信息拼接成一个字符串。

写入文件

1 | fs.write(all + '\n\n') |

运行结果

转载前请认真阅读本站 版权协议,文章采用 CC BY-NC-SA 4.0 许可协议

💬评论

翻转卡片~

查看我的联系方式

如有事情

请扫一扫🔎

添加微信好友